- A

- A

- A

- АБB

- АБB

- АБB

- А

- А

- А

- А

- А

- Национальный исследовательский университет «Высшая школа экономики»

- Кафедра ЮНЕСКО по исследованиям будущего

- Новости

- ИИ для кибербезопасности: тренды и востребованность

-

Кафедра

-

Образовательная деятельность

-

Научная деятельность

Москва, Мясницкая 11,

+7 (495) 621-28-73,

issek@hse.ru

Гохберг Л. М., Куценко Е. С., Боос В. О. и др.

М.: ИСИЭЗ ВШЭ, 2024.

Искусственный интеллект в России: технологии и рынки

Искусственный интеллект в России: технологии и рынки

Вишневский К. О., Туровец Ю. В., Гохберг Л. М.

М.: Издательский дом НИУ ВШЭ, 2025.

Абашкин В. Л., Абдрахманова Г. И., Вишневский К. О. и др.

М.: НИУ ВШЭ, 2025.

Гохберг Л. М., Дитковский К. А., Евневич Е. И. и др.

М.: ИСИЭЗ НИУ ВШЭ, 2025.

Абашкин В. Л., Абдрахманова Г. И., Вишневский К. О. и др.

М.: НИУ ВШЭ, 2025.

Власова В. В., Гохберг Л. М., Грачева Г. А. и др.

М.: ИСИЭЗ НИУ ВШЭ, 2025.

Искусственный интеллект в России: технологии и рынки

Искусственный интеллект в России: технологии и рынки

Вишневский К. О., Туровец Ю. В., Гохберг Л. М.

М.: Издательский дом НИУ ВШЭ, 2025.

Будущее мировой науки

Будущее мировой науки

Гохберг Л. М., Кузнецова Т. Е., Мильшина Ю. В. и др.

М.: Издательский дом НИУ ВШЭ, 2024.

Jonathan Calof, Colton B.

Technological Forecasting and Social Change. 2024. Vol. 198.

Веселитская Н. Н., Шашнов С. А.

Форсайт. 2024. Т. 18. № 1. С. 80-91.

ИИ для кибербезопасности: тренды и востребованность

Институт статистических исследований и экономики знаний НИУ ВШЭ представляет обзор трендов применения решений на основе искусственного интеллекта (ИИ) для цифровой безопасности и изучает их использование среди российских организаций.

Оценки основаны на результатах обследования 2,5 тыс. организаций 20 отраслей экономики (обрабатывающая промышленность, торговля, финансы и страхование, транспорт и логистика, ИТ-отрасль, телекоммуникации и др.), проведенного ИСИЭЗ НИУ ВШЭ в конце 2023 г.

Настоящий выпуск подготовлен в рамках проекта «Мониторинг технологического развития искусственного интеллекта в Российской Федерации» тематического плана научно-исследовательских работ, предусмотренных Государственным заданием НИУ ВШЭ.

В 2023 г., по данным InfoWatch, в мире зафиксировано 11 549 утечек данных (порядка 30 ежедневно), на каждую из них в среднем приходилось более 4 млн записей персональных данных. На рост количества атак (+61,6% к 2022 г.) влияет, в том числе, распространение технологий ИИ (генеративных моделей, дипфейков, ботов, усложнение техник социальной инженерии и др.).

Решения на основе ИИ также помогают предотвращать атаки злоумышленников: перспективные методы машинного обучения применяются для определения поддельных данных (включая аудио- и видео-), выявления и прогнозирования действий нарушителей, в целом более эффективной защиты электронных систем, информационных сетей и различных устройств (компьютеров, серверов, мобильных телефонов). По некоторым оценкам, внедрение инструментов ИИ и автоматизации сокращает время реагирования на инциденты кибербезопасности с 2,3 дней до 58 минут.

Основные направления применения ИИ в кибербезе

Среди ИИ-инструментов обеспечения цифровой безопасности наиболее популярны системы прогнозирования новых угроз, обученные обнаруживать закономерности на данных о ранее совершенных атаках. Разработка таких систем предполагает создание базы угроз, и ключевой задачей тут становится анонимизация персональных и коммерческих данных (обезличивание обучающих датасетов). При эксплуатации системы прогнозирования важной задачей, наряду с предотвращением утечки данных, является также недопущение искажений внутренней логики ее ИИ-модели.

Минимизировать возможности киберугроз со стороны внутренних нарушителей (инсайдеров) позволяют методы поведенческой аналитики сотрудников. Их применение считают необходимым 87% руководителей подразделений по информационной безопасности крупнейших мировых компаний. Согласно InfoWatch, с утечкой данных по вине увольняющихся сотрудников сталкивались 73% организаций. «Лидирует» в данном отношении сфера образования, где подобные происшествия случались в 95% организаций. С компрометацией конфиденциальных и корпоративных данных по вине действующих и бывших сотрудников только за последние годы столкнулся целый ряд транснациональных корпораций (Google, Tesla, Disney и др.), а также Пентагон. Поскольку частым следствием утечек является финансовый и репутационный ущерб, крупные компании уделяют повышенное внимание мониторингу поведенческих паттернов персонала (отслеживание по критериям аномального вывода информации, нетипичных внешних коммуникаций, снижения производительности и иной активности) и автоматизированной оценке рисков, включая профилирование пользователей и рейтингование подозрительных сотрудников.

Набирают популярность ИИ-решения для блокировки ботов на основе анализа их активности. В 2023 г. боты сгенерировали почти половину сетевого трафика (49,6%), причем треть общего трафика (32%) — вредоносные боты, используемые для атак на сайты компаний, кражи конфиденциальных данных, мошеннических операций, нанесения вреда репутации конкурентов и др.

Генеративные модели могут, среди прочего, анализировать уязвимости кода, собирать расширенный контекст событий в сфере информационной безопасности, генерировать на основе идентификаторов пояснения по обнаруженным угрозам, выявлять неявные связи в системе. Для обнаружения фишинговых сообщений применяется функция выявления текста, написанного с помощью ИИ.

Востребованность в России

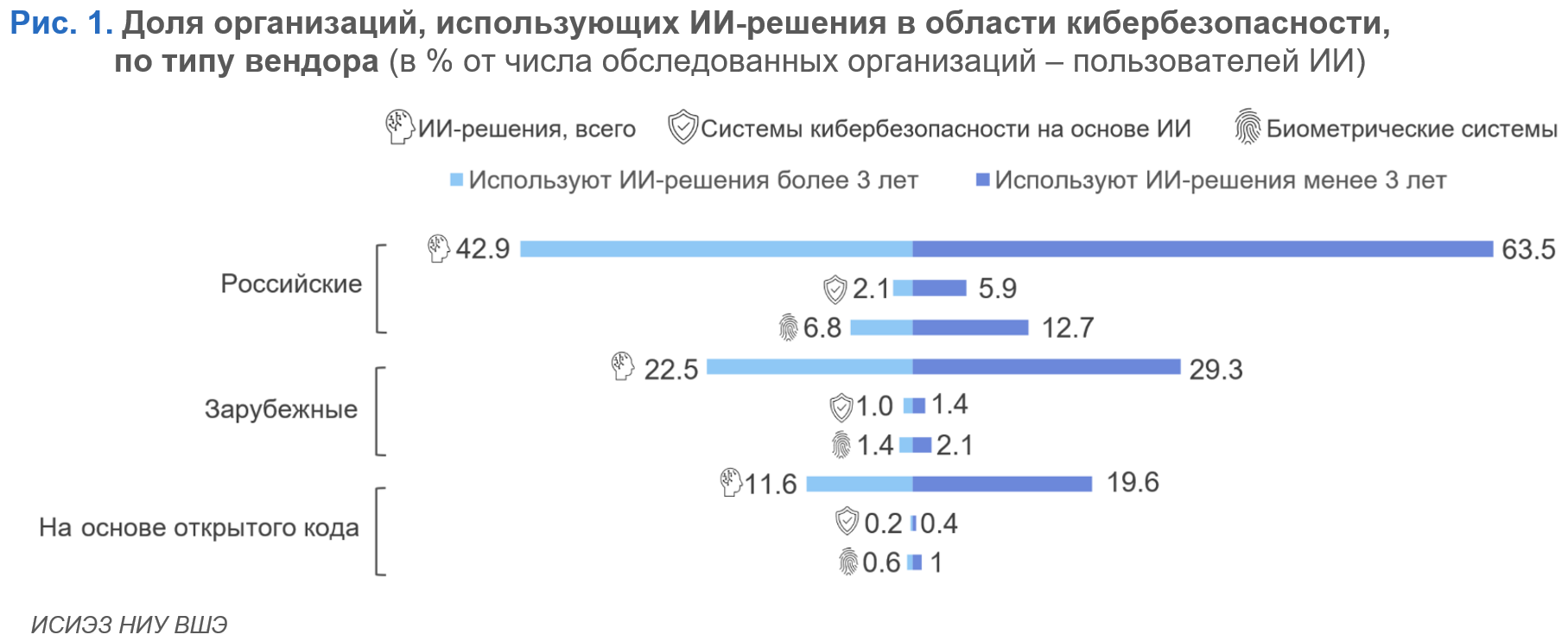

Согласно результатам обследования организаций, проведенного ИСИЭЗ НИУ ВШЭ, отечественные инструменты ИИ в целом более востребованы у организаций, использующих такие технологии менее трех лет (63,5%). Вдвое чаще «новички» используют российские ИИ-системы кибербезопасности (5,9%) и системы биометрии (12,7%) (рис. 1). У зарубежных вендоров эти два класса решений приобретаются существенно реже (1,4% и 2,1% соответственно).

Решения на основе открытого кода крайне ограниченно востребованы в системах кибербезопасности и биометрии (0,4 и 1% организаций, использующих ИИ менее трех лет, и 0,2 и 0,6% — среди пользователей с опытом более трех лет соответственно), что связано не только с обработкой корпоративных данных, угрозой их компрометации, но и скрытыми рисками опенсорса. В базе Лаборатории Касперского содержатся данные по более 20 тыс. вредоносным пакетам с открытым исходным кодом в популярных репозиториях1.

И хотя инструменты на основе ИИ в целом и в частности применяемые для обеспечения безопасности физической и цифровой среды — относительно новое явление в корпоративной цифровой архитектуре, интерес к ним постепенно повышается. Так, среди компаний, использующих ИИ, каждая вторая планирует расширить уровень применения ИИ-решений и примерно каждая шестая намерена шире использовать как системы кибербезопасности, так и более понятные для бизнеса биометрические системы идентификации и аутентификации (16,3 и 16,5% соответственно) (рис. 2). В то же время интеграция подобных систем в ИТ-инфраструктуру компаний происходит с некоторой задержкой. Это объясняется необходимостью проведения дополнительной оценки рисков и угроз при внедрении ИИ, так как подобные системы работают с информацией различной степени доступности. В дополнение к этому компаниям необходимо обеспечить соблюдение требований внутренней политики безопасности и законодательных норм в отношении ИИ, в том числе стандартов, которые только формируются.

Резюме

Cпрос на ИИ-решения в области кибербезопасности со стороны компаний в ближайшие годы будет расти как в России, так и в мире. Этому будет способствовать все большая цифровизация производственных и бизнес-процессов и, в частности, распространение прорывных ИИ-инструментов (генеративного ИИ, мультимодальных нейросетей и др.), сопровождающееся появлением новых угроз. Комплексный подход к укреплению цифровой архитектуры должен предусматривать, помимо применения средств аналитики и защиты, повышение цифровой грамотности персонала и своевременную актуализацию политик безопасности. Подробнее о том, как компании могут повысить безопасность использования ИИ, читайте в следующем выпуске серии.

Предыдущий выпуск серии «Искусственный интеллект»:

«Освоение технологий искусственного интеллекта студентами вузов»

См. также:

- О ВЫШКЕ

- Цифры и факты

- Руководство и структура

- Устойчивое развитие в НИУ ВШЭ

- Преподаватели и сотрудники

- Корпуса и общежития

- Закупки

- Обращения граждан в НИУ ВШЭ

- Фонд целевого капитала

- Противодействие коррупции

- Сведения о доходах, расходах, об имуществе и обязательствах имущественного характера

- Сведения об образовательной организации

- Людям с ограниченными возможностями здоровья

- Единая платежная страница

- Работа в Вышке

- ОБРАЗОВАНИЕ

- Лицей

- Довузовская подготовка

- Олимпиады

- Прием в бакалавриат

- Вышка+

- Прием в магистратуру

- Аспирантура

- Дополнительное образование

- Центр развития карьеры

- Бизнес-инкубатор ВШЭ

- Образовательные партнерства

- Обратная связь и взаимодействие с получателями услуг

-

http://www.minobrnauki.gov.ru/

Министерство науки и высшего образования РФ

-

https://edu.gov.ru/

Министерство просвещения РФ

-

http://www.edu.ru

Федеральный портал «Российское образование»

-

https://elearning.hse.ru/mooc

Массовые открытые онлайн-курсы

- © НИУ ВШЭ 1993–2025 Адреса и контакты Условия использования материалов Политика конфиденциальности Карта сайта

- Редактору